Wir sind unabhängig, neutral und finanzieren uns teilweise über Werbung und Partnerprovisionen.

Danke wenn du uns unterstützt. Weitere Infos zum Bedanken findest Du hier.

Diese Seite verwendet hierzu Cookies & Tracking-Cookies, weitere Informationen findest du hier. Wenn du diese Seite weiterhin besuchst, erklärst du dich damit einverstanden.

Diese seite ist neutral und unabhängig. Die Finanzierung erfolgt teilweise über Werbung und Partnerprovisionen.

Danke wenn Du mich unterstützt.

Diese Seite verwendet Cookies & Tracking-Cookies, weitere Informationen findest Du hier. Wenn du diese Seite weiterhin besuchst, erklärst du dich damit einverstanden.

Handbuch:

Linux optimal installieren

© www.ctaas.de # 2023-10-26

Linux einfach installieren - wie man ein kleines, stabiles & sicheres System aufsetzt. Deutsche/German Debian/Ubuntu Anleitung:

| Nr. |

Admin Handbuch Inhalt: |

| 1 |

Vorüberlegungen |

| 2 |

Grundsystem Empfehlungen (DVD-Links) |

| 3 |

root bzw. sudo Passwort festlegen |

| 4 |

Paketquellen aktualisieren/Updates installieren |

| 5 |

Linux Desktopumgebungen im Vergleich |

| 6 |

Autologon |

| 7 |

Netzwerkeinstellungen anpassen (network/interfaces bzw. netplan) |

| 8 |

hosts-Datei/WINS/NetBIOS Hostnamen auflösen (winbind) (bind9) |

| 9 |

Netzwerk browsing (durchsuchen) aktivieren |

| 10 |

häufig empfohlene Zusatzprogramme |

| 11 |

Paketquellen (CDs/DVDs) entfernen |

| 12 |

Terminal Consolen Font ändern & Tipps zur Console |

| 13 |

Grafische Fernsteuerung/Fernwartung der Server |

| 14 |

vsftpd (FTP-Server/FTPS-Server) sicher einrichten |

| 15 |

OpenSSH-Server (SFTP-Server/SSH Secure Shell) einrichten |

| 16 |

Samba Dateiserver mit Papierkorb in Netzlaufwerken einrichten |

| 17 |

Apache2 Webserver mit PHP einrichten |

| 18 |

MySQL Datenbank-Server (mit PHP und Apache Anbindung) installieren |

| 19 |

transparenter Bildschirmschoner |

| 20 |

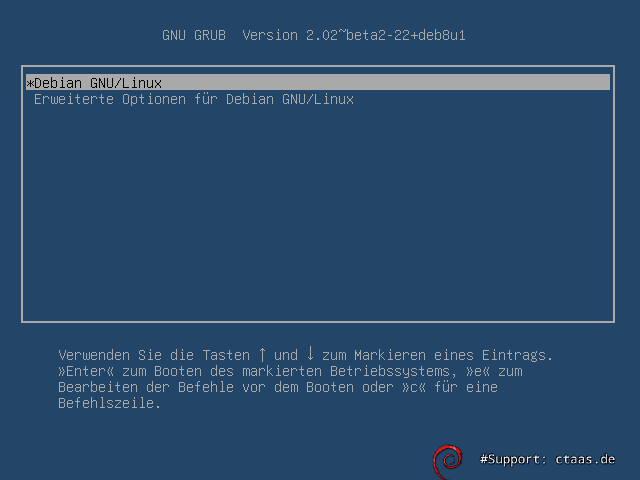

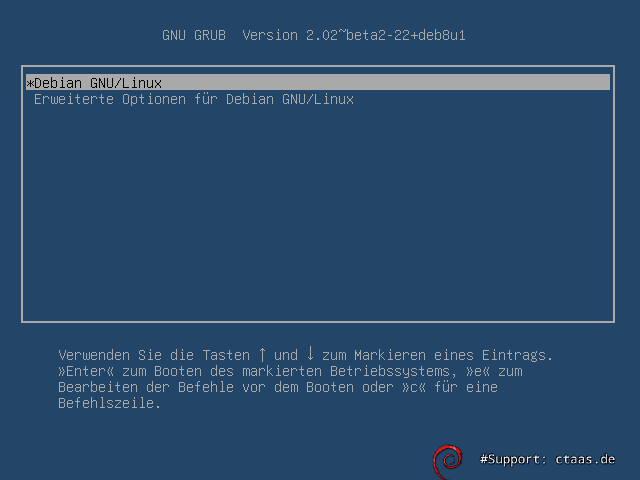

GRUB 2 (Consolenauflösung und Splash-Screen) anpassen |

| 21 |

Ubuntu auf eine neue Version aktualisieren (Upgrade) |

| 22 |

BitDefender Virenscanner von einem Live-System aus nutzen (Ubuntu) |

| 23 |

Linux sichern (MBR, Partitionstabellen, Partitionen ...) |

| 24 |

GRUB 2 von einem Live System aus reparieren (Linux MBR reparieren) |

| 25 |

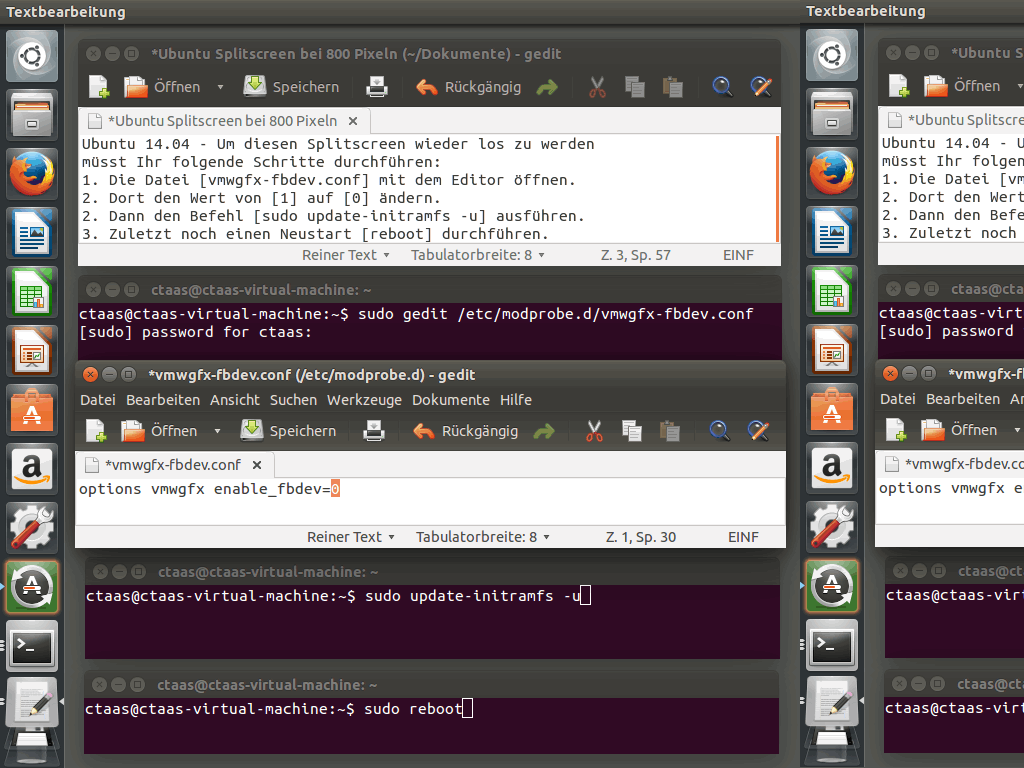

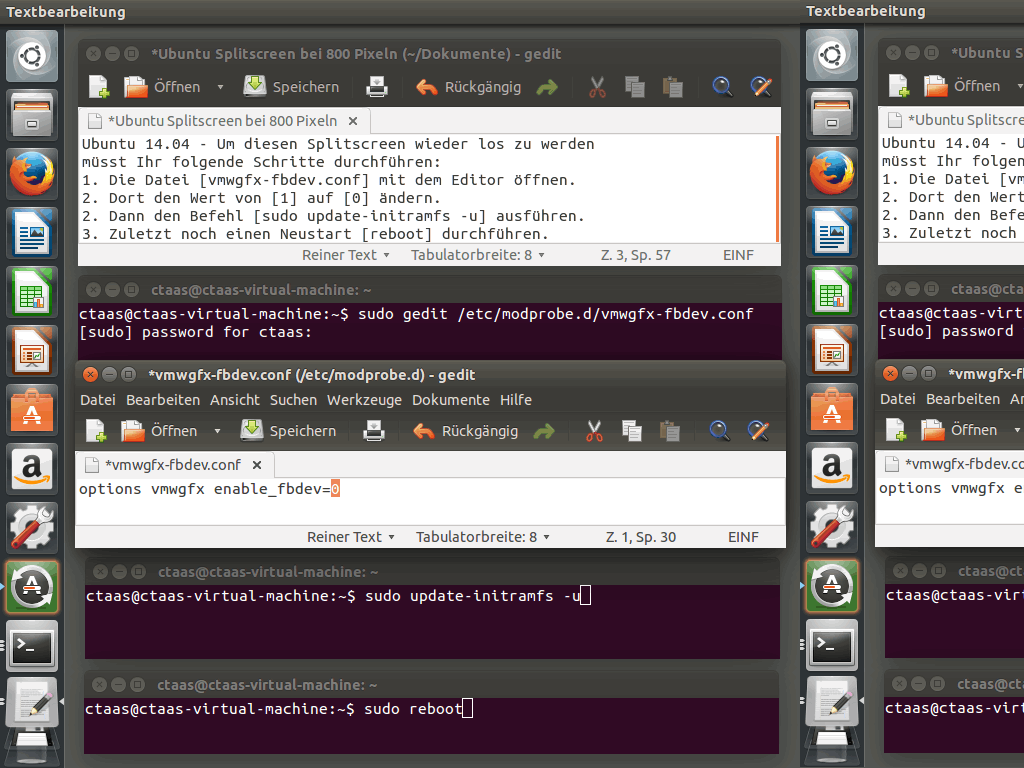

VMWare ESXi Problemlösung: horizontal gespiegelte Darstellung |

| 26 |

VirtualBox VMs per Batch starten und beenden |

| 27 |

Datenrettung gelöschte Bilder/Fotos wiederherstellen (recoverjpeg) |

| 28 |

Datenrettung mit photorec |

| 29 |

Datenrettung mit foremost |

| 30 |

Datenrettung/Undelete mit tsk_recover |

| 31 |

Paketquellen/Repositories hinzufügen und verwalten |

| 32 |

doppelte Dateien löschen: FSlint (file system utilities) |

| 33 |

doppelte Dateien löschen: duff (DUplicate File Finder) |

| 34 |

doppelte Dateien löschen: rdfind (redundant data find) |

| 35 |

.eml Dateien entpacken |

| 36 |

Foto Dateinamen vereinheitlichen/mit Datum versehen und sortieren (exiftool) |

| 37 |

Bilder konvertieren: bmp in png (mit ImageMagick) |

| 38 |

Bilder konvertieren: jpg/jpeg & png in webp (mit cwebp) |

| 39 |

Bilder konvertieren: gif Bilder & Animationen in webp (mit cwebp) |

| 40 |

Bilder konvertieren: avif, heic, png, jpg umwandeln (libheif/heif-convert) |

| 41 |

guetzli: png in jpg konvertieren (optimiert für Webseiten) |

| 42 |

zopfli: png, htm, html, php, css, js, xml ... Dateien optimal packen |

| 43 |

advpng: png ... Dateien optimal packen (alternative Variante) |

| 44 |

brotli: htm, html, php, css, js, xml ... Dateien optimal packen |

| 45 |

lepton: jpg/jpeg verlustfrei im lep Format packen (zum archivieren) |

| 46 |

flif: png ... Dateien optimal packen (Free Lossless Image Format) |

| 47 |

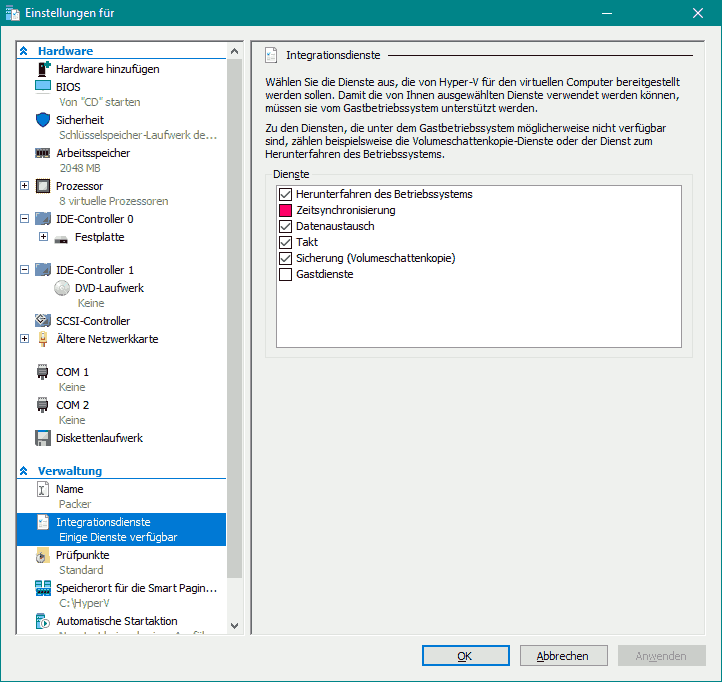

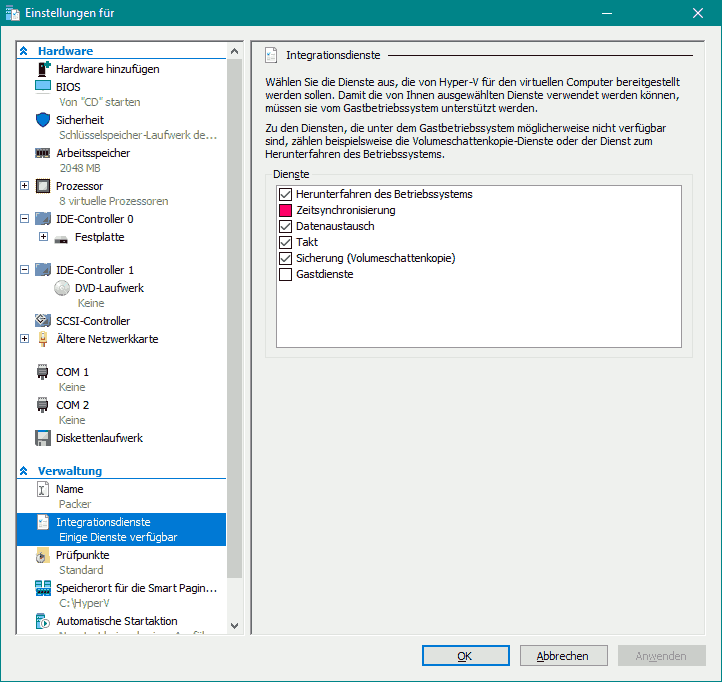

Bildschirmauflösung einer Hyper-V VM ändern |

| 48 |

UTC Zeitzone anpassen für Ubuntu mit systemd (pool.ntp.org) |

|

Linux Kurzreferenz: Wichtige Linux Shell-Befehle und Programme (Sortiert von A-Z)

|

|

addgroup,

adduser,

alias,

blkid (block device attributes),

cat (concatenate),

cd (change directory),

chattr (change file attributes),

chmod (change file mode bits),

chown (change owner),

chpasswd (change password),

cp (copy),

cut (ausschneiden),

date/hwclock/cal/ntpdate (Zeitangaben ausgeben und setzen),

dd (disk dump),

debconf-show,

delgroup,

deluser,

df (disk free),

diff (difference),

dosfsck,

dpkg-reconfigure,

du (disk usage),

e2fsck (ext filesystem check, chkdsk),

echo,

env (environment),

$? (errorlevel),

exit & logout,

fdisk,

file,

find,

for do done (for Schleife) ,

free,

fsarchiver (filesystem archiver),

fsck (file system check),

grep,

groups (Gruppen),

htop,

gzip,

hdparm,

head,

hostname,

hostnamectl,

id (identification),

if,

iotop,

ip,

journalctl,

kill,

killall,

ln (link),

ls (list),

lsattr (list file attributes),

lsb_release (Linux Standard Base Specification),

lsblk (list block devices),

lshw (list hardware),

mail,

more,

mount,

mkdir (make dir),

mkfs (make filesystem),

mv (move),

nmap,

nohup (no hangup),

NVMe (NVM Express),

partclone ,

passwd (password),

ps (processes),

pv (monitor the progress of a data throuh a pipe),

pwd (print working directory),

qrencode,

reboot,

rm (remove),

rmdir (remove directory),

sed (stream editor),

setterm,

shred,

shutdown,

sleep,

sort,

stat (display file system status),

su (superuser),

sudo (superuser do),

tail,

tar,

tee,

timedatectl (control the system time and date),

top,

touch (change file timestamps),

tune2fs,

uname,

xset

|

Die nachfolgende Dokumentation ist für Ubuntu und Debian geeignet.

Erklärt wird in wenigen einfachen Schritten wie man eine optimale Linux Umgebung installiert.

Diese Anleitung ist für Linux Systeme mit Desktop sowie auch für reine Server ohne grafische XServer nutzbar.

Wer noch nicht weiß welche Linux Desktop-Umgebung optimal ist, der findet hier noch einen Ressourcen-Vergleich.

In den nachfolgenden Schritten werden dann verschiedenste wichtige Programme, Tipps sowie einige Server Dienste vorgestellt.

1. Vorüberlegungen für Desktops:

Verglichen wurden insbesondere Desktops die:

- stabil & ressourcenschonend arbeiten,

- möglichst auf 3D-Effekte & Bling-Bling verzichten,

- schnelles und flüssiges Arbeiten ermöglichen,

- in VMs gut laufen und

- regelmäßig gut gepflegt werden (Sicherheit).

Des Weiteren sollten heutzutage gängige Desktopfunktionen bereit stehen:

- ein Taskmanager (zum überwachen von Ressourcen und Netzwerk-Traffic),

- ein Terminal (mit veränderbaren Fonts),

- ein Dateimanager mit Netzwerkfunktionalität (browse Netzwerk),

- ein grafischer Editor zum bequemen Editieren von Konfigurationsfiles,

- ein Webbrowser zum Surfen im Internet (z. B. mit Firefox),

- Tools für grundlegende Systemeinstellungen wie z. B. Font-Einstellungen, statische Netzwerkadressenvergabe oder WLAN-Konfiguration,

- Benachrichtigungen des Users bei Updates (sofern kein Autoupdate aktiviert wurde).

Alle weiteren Anwendungen aus dem Office-, Grafik-, Musik-, Server-Bereich usw. wurden nicht berücksichtigt.

Der Anwender muss sich die entsprechenden Anwendungen je nach Verwendungszweck selbst nachinstallieren.

Es geht hier also darum ein möglichst kleines, schlankes und stabiles Grundsystem zu erhalten auf das man dann aufbauen kann.

2. Ein Grundsystem ist Voraussetzung:

Will man ein möglichst aufgeräumtes System ohne jeglichen Schnickschnack,

so sollte man anfangs nur eine Server Version ohne GUI installieren. Voraussetzung ist am besten eine neue Linux Installation.

Man installiert zuerst ein Standard Server Setup der gewünschten Distribution (Ubuntu oder Debian).

Unterschiedliche Setup-Medien findet man hier:

Für Ubuntu:

Die Server-DVD ist für ein kompaktes Ubuntu-System eine Voraussetzung (empfohlen).

Die Ubuntu-Desktop-DVD

bzw. die Xubuntu-Desktop-DVD starten jeweils ein Live-System (dieses ist für Tests, Reparaturzwecke, sowie zur Installation geeignet).

Für Debian:

Das Stable-Livesystem ist für Tests, zum Installieren, sowie für Reparaturen geeignet.

Hier findet man das komplette Debian (geeignet für alle Installationsarten - ebenso empfohlen).

In der Regel reicht hier ein Download der ersten CD/DVD aus, denn diese enthält alle Dateien für ein Standard-Debian-System.

Alle weiteren Medien benötigt man nur, wenn man weitere Pakete für eine komplette offline Installation benötigt.

Ältere Versionen kann man hier im Debian Archiv herunterladen.

Hinweis:

Ein Setup von einer Desktop-Live-DVD, installiert immer einen kompletten Desktop, mit allen Anwendungen.

Daher wird ein Setup von einer Desktop-Live-DVD nicht empfohlen.

3a. unter Ubuntu - das root Passwort setzen (optional):

Sofern dies noch nicht bei der Installation geschehen ist, sollte man jetzt noch das root-User-Passwort setzen:

sudo passwd root

Im Terminal muss man nun das neue Passwort vergeben.

3b. unter Debian - dem Standard-Benutzer sudo Rechte zuweisen (optional):

Will man dem normalen Standard Debian User sudo Rechte zuweisen so sind folgende Schritte durchzuführen:

Anmelden als root entweder über ein entsprechendes root-Terminal oder mittels:

su

Achtung: Es wird hierbei das root User Passwort nicht das Passwort vom angemeldeten User abgefragt.

Danach sollte man das sudo package installieren (sofern noch nicht vorhanden):

apt-get install sudo

Danach kann man dem User die sudo Rechte wie folgt zuweisen:

gpasswd -a UserName sudo

Die Änderung wird erst nach einer Neuanmeldung (An-/Abmeldung am System) übernommen, am schnellsten:

reboot

Sicherheitshinweis: Die sudo Rechte erweitern die Rechte des Users!

Sicherheitstechnisch sollte man abwägen was wichtiger ist.

Mehr Bequemlichkeit, dann aktiviert sudo,

mehr Sicherheit dann verwendet nur root mit einem starken Passwort zur Einrichtung.

Den User wieder aus der sudo-Gruppe entfernen:

gpasswd -d UserName sudo

4. Paketquellen einlesen/aktualisieren & Updates installieren (empfohlen):

Bevor man ans weitere installieren geht, sollte man die Paketquellen neu einlesen (auf Updates prüfen)

und diese Updates ggf. erst einspielen (upgrade):

apt-get update # Paketquellen aktualisieren (vor jedem Update notwendig).

apt-get list --upgradeable # Alle verfügbaren Update-Pakete anzeigen.

apt-get --simulate dist-upgrade # Änderungen am System werden nur Simuliert.

apt-get upgrade # Bestehende Programm-Pakete aktualisieren. Es werden keine neuen Programm Versionen (upgrades) installiert.

apt-get --with-new-pkgs upgrade # Die Pakete werden in der neuesten Version istalliert, es werden entsprechende Abhängigkeiten berücksichtigt. Dies Entspricht sozusagen einem 'dist-upgrade'. Das System wird danach aber nicht bereinigt.

apt-get install --reinstall Paketname # Installiert ein Paket nochmal neu (kann bei Fehlern helfen).

apt-get dist-upgrade # Auch neue Programmpakete/Programm Versionen installieren (empfohlen).

apt-get autoremove # Alte nicht mehr benötigte Pakete wieder löschen. Will man auch alte Kernel-Versionen löschen, so muss man ggf. zuvor den grub-Bootloader aktualisieren [update-grub].

apt-get autoclean # Heruntergeladene aber nicht mehr gepflegte Pakete löschen.

Erst danach sollte man mit der Installation des eigentlichen Desktops beginnen.

Sauberes entfernen von nicht mehr benötigten Paketen:

apt-get remove Paketname # Deinstalliert das angegebene Paket.

apt-get autoremove Paketname # Deinstalliert das angegebene Paket einschließlich aller nicht mehr benötiger Abhängigkeiten.

apt-get purge Paketname # Deinstalliert das angegebene Paket und entfernt alle dazugehörigen Konfigurationsdateien,

notwendig ist dies z. B. beim Wechsel von PHP5 auf PHP7 oder bei einem Desktopwechsel - ein Parallelbetrieb ist hier meist nicht vorgesehen.

Um Problemen aus dem Weg zu gehen sollte man bei derartigen Paketen zuerst das alte Paket mittels purge entfernen und erst dann das neue Paket installieren.

apt-cache search Suchbegriff | more # Sucht nach möglichen Paketen. Hilfreich, wenn man nicht genau weiß welches man nehmen soll.

5. Fenstermanager-Installation:

Nun kann man sich für einen Fenstermanager (eine Desktopumgebung) entscheiden.

Vorstellen möchte ich hier folgende:

| Xfce |

MATE Desktop Environment |

Gnome |

LXDE |

LXQt |

IceWM |

Cinnamon |

(Ubuntu) Unity |

KDE Plasma |

| Empfehlung: 100 % |

Empfehlung: 90 % |

Empfehlung: 80 % |

Empfehlung: 70 % |

z. Z. nicht Empfohlen |

nicht Empfohlen |

nur bedingt Empfohlen |

Entwicklung eingestellt |

nicht Empfohlen |

![Screenshot: xfce4 + xfce4-terminal + gnome-icon-theme + fonts-croscore [Xfce4] unter Debian 8. Ansicht vergrößern über klick oder zoom. Xfce Screenshot unter Debian 8.](https://ctaas.de/images/Linux/Xfce4-web.png)

- ist über die offiziellen Paketquellen verfügbar,

- hat einen klassischen Look,

- ist schnell und ressourcenschonend,

- sowie sehr stabil und zukunftssicher, da es sehr ausgereift ist und regelmäßig weiter entwickelt wird,

- die aktuelle Version heißt derzeit Xfce4,

- Xfce wird für Server, Desktop und VM empfohlen,

- verwendet das GTK+-Toolkit.

'universe' Paketquelle hinzufügen (Optional/ab Ubuntu 18.04):

add-apt-repository universe

Folgendes installiert den Xfce4 Desktop bis Ubuntu 18.10:

apt-get install xfce4

Ab Ubuntu 19.04

verändertes xfce4 package (neue Empfehlung zur Installation):

apt-get install --no-install-recommends xfce4 xorg xserver-xorg-video-all elementary-xfce-icon-theme

Ergänzende Parametererklärungen für ein kompaktes Setup findet ihr hier.

ergänzend ab Ubuntu 20.10:

deutsches Sprachpaket nachinstallieren:

Zuerst die Sprach-Pakete herunterladen:

apt install language-pack-gnome-de

Dies aktiviert nach einem Neustart das deutsche Tastaturlayout.

Danach kann man wie folgt die Sprache im System komplett auf Deutsch umstellen:

update-locale LANG=de_DE.UTF-8 && reboot

System-Sprache auf Deutsch umstellen Alternative:

dpkg-reconfigure locales && reboot

hier dann [*] de_DE.UTF-8 UTF-8 und de_DE.UTF-8 auswählen. Auch hier ist dann noch ein Systemneustart notwendig.

Beachtet dass beim nachinstallieren von anderen Programmen wie Office, Firefox usw. ggf. weitere entsprechende Sprach-Pakete für diese zusätzlichen Programme notwendig sein können.

Folgendes installiert die für Ubuntu angepasste Version (weniger empfohlen):

apt-get install xubuntu-desktop

Folgendes installiert die angepasste Ubuntu Studio Version (die Multimedia Version zum bearbeiten von Audio-, Video- und Bild-Dateien) (weniger empfohlen):

apt-get install ubuntustudio-desktop

Weitere Zusätze (wie z. B. CD/DVD-Brennprogramm) installiert man über:

apt-get install xfce4-goodies

Sollten Icons fehlen, so installiert man einfach:

apt-get install gnome-icon-theme

bzw.:

apt-get install gnome-icon-theme-full

bzw.:

apt-get install xubuntu-icon-theme

Tastenkürzel:

Windows+e Editor,

Windows+f Explorer,

Windows+m E-Mail,

Windows+t Terminal,

Windows+w Webbrowser

starten.

|

![Screenshot: mate-desktop-environment-core + mate-system-monitor + fonts-croscore [MATE] unter Debian 8. Ansicht vergrößern über klick oder zoom. MATE Desktop Umgebung (core) Debian 8 Screenshot](https://ctaas.de/images/Linux/MATE-web.png)

- ist ein Fork von Gnome 2,

- hat einen klassischer Look,

- ist relativ neu, wird aber stetig weiter entwickelt,

- ab Ubuntu 14.10 und Debian 8

ist MATE über die offiziellen Paketquellen verfügbar,

- wird für Desktops empfohlen.

- verwendet das GTK+-Toolkit.

'universe' Paketquelle hinzufügen (Optional/ab Ubuntu 18.04):

add-apt-repository universe

Folgendes installiert den MATE-Desktop mit allen zusätzlichen Komponenten (empfohlen):

apt-get install xorg mate-desktop-environment-extras

Folgendes installiert den MATE Desktop:

apt-get install xorg mate-desktop-environment

Folgendes installiert nur den minimalen MATE Desktop ohne jegliche Extras (mit Brisk-Menü):

apt-get install xorg mate-desktop-environment-core mate-applet-brisk-menu

Folgendes installiert ab Ubuntu 15.04 den für Ubuntu angepassten kompletten MATE Desktop (weniger empfohlen):

apt-get install ubuntu-mate-desktop

Die Benachrichtigungsleiste nachinstallieren (optional):

apt-get install mate-notification-daemon

Unter Ubuntu sollte man diesen Font nachinstallieren, um die Terminaldarstellung zu verbessern (optional):

apt-get install ttf-ubuntu-font-family |

![Screenshot: xorg gnome-core + gnome-session-flashback + fonts-croscore [Gnome + flashback (Metacity)] unter Debian 8. Ansicht vergrößern über klick oder zoom. Gnome flashback (core) Debian 8 Screenshot](https://ctaas.de/images/Linux/GNOME-flashback-web.png)

- moderner & klassischer Look,

- wird ständig weiter entwickelt,

- ist stabil und zukunftssicher,

- für leistungsstärkere Desktops empfohlen,

- verwendet das GTK+-Toolkit.

'universe' Paketquelle hinzufügen (Optional/ab Ubuntu 18.04):

add-apt-repository universe

Folgendes installiert den Gnome 3 Desktop:

apt-get install xorg gnome-core

gnome-session-flashback

Parameterbeschreibung:

gnome-core - installiert den Gnome 3 Desktop, dieser benötigt möglichst einen Grafiktreiber der Video und 3D beschleunigt.

gnome-session-flashback installiert zusätzlich - GNOME Flashback (Metacity) - einen sparsamen 2D Desktop.

Bei der Anmeldung kann man dann über das Zahnradicon auswählen welcher Desktop gestartet werden soll.

Der zuletzt gewählte Eintrag wird automatisch als Default-Desktop eingestellt. |

![Screenshot: xorg lxde-core + lxterminal + fonts-croscore [LXDE] unter Debian 8. Ansicht vergrößern über klick oder zoom. LXDE Screenshot unter Debian 8.](https://ctaas.de/images/Linux/LXDE-web.png)

- klassischer Look,

- wird gut gepflegt und ist daher stabil und zukunftssicher,

- für Server und Desktops gleichermaßen geeignet,

- für VMs sehr empfohlen da sehr ressourcenschonend,

- verwendet das GTK+-Toolkit.

'universe' Paketquelle hinzufügen (Optional/ab Ubuntu 18.04):

add-apt-repository universe

Folgendes installiert den LXDE Desktop (empfohlen):

apt-get install xorg lxde-core

Folgendes installiert eine für Ubuntu angepasste LXDE Version (weniger empfohlen):

apt-get install xorg lubuntu-core

Das Aussehen/Thema lässt sich anpassen über:

apt-get install lxappearance

Bei einer Installation unter VirtualBox (als VM) muss man noch folgendes Installieren:

apt-get install build-essential dkms

|

![Screenshot: lxqt-metapackage openbox + lxtask + fonts-croscore [LXQt] unter Ubuntu 14.10. Ansicht vergrößern über klick oder zoom. Screenshot: LXQt 0.9.0 mit Openbox.](https://ctaas.de/images/Linux/LXQt_mit_Openbox-web.png)

- klassischer Look,

- relativ neu, wird erst entwickelt (noch nicht 100 % stable),

- daher zur Zeit keine Empfehlung für Server, Desktop oder VM,

- LXQt ist noch nicht in den offiziellen Quellen von Ubuntu und Debian enthalten,

- ist eine auf Qt basierende LXDE Umgebung.

'universe' Paketquelle hinzufügen (Optional/ab Ubuntu 18.04):

add-apt-repository universe

Folgendes installiert ab Ubuntu 18.04 den LXQT Desktop:

apt install lxqt-core openbox

Installationsanleitung für Ubuntu:

1. folgende Paketquelle hinzufügen (nur bei alten Versionen):

add-apt-repository ppa:lubuntu-dev/lubuntu-daily

2. Alle Paketquellen neu einlesen:

apt-get update

3. LXQt installieren:

apt-get install lxqt-metapackage openbox

Die Installation unter Debian wird derzeit nicht empfohlen. Derzeit (Stand: 2015-03-05) ist hier alles noch eine Baustelle.

Sollte man es doch versuchen, so sollte man zuerst den Befehl [add-apt-repository] nachinstallieren, sodass man Paketquellen hinzuzufügen kann:

apt-get install software-properties-common

Anschließend sollte man nach einer Installationsanleitung googeln.

|

![Screenshot: xorg icewm + pcmanfm + lxterminal + lxtask + fonts-croscore [IceWM] unter Debian 8 mit Win95 Theme. Ansicht vergrößern über klick oder zoom. IceWM Screenshot unter Debian 8](https://ctaas.de/images/Linux/IceWM-web.png)

- alter Windows Look,

- alt, aber sehr ressourcensparend,

- für Desktops eher weniger empfohlen, da doch sehr schlicht.

'universe' Paketquelle hinzufügen (Optional/ab Ubuntu 18.04):

add-apt-repository universe

Folgendes installiert den IceWM Desktop:

apt-get install xorg icewm

optionale Themes (z. B. SilverXP) installieren:

apt-get install icewm-themes |

![Screenshot: xorg cinnamon-core + gnome-system-monitor + fonts-croscore [Cinnamon] unter Debian 8. Ansicht vergrößern über klick oder zoom. Cinnamon Screenshot unter Debian 8.](https://ctaas.de/images/Linux/Cinnamon-web.png)

- ist ab Ubuntu 14.10 und Debian 8 über die Standard Paketquellen verfügbar,

- ist ein Fork von GNOME bzw. der GNOME Shell,

- benötigt einen Grafiktreiber der Video und 3D beschleunigt,

- als fall-back wird ein Software-Rendering-Modus verwendet, der jedoch eine erhöhte CPU-Auslastung bewirkt,

- daher eine sehr hohe CPU Last in VMs,

- für leistungsstarke Desktops durchaus empfohlen,

- wird hauptsächlich in Linux Mint eingesetzt.

'universe' Paketquelle hinzufügen (Optional/ab Ubuntu 18.04):

add-apt-repository universe

Folgendes installiert den Cinnamon Desktop:

apt-get install xorg cinnamon-core

Folgendes installiert Cinnamon mit allen zusätzlichen Anwendungen:

apt-get install xorg cinnamon-desktop-environment |

![Screenshot: ubuntu-desktop + fonts-croscore [Unity] unter Ubuntu 15.04. Ansicht vergrößern über klick oder zoom. Unity Screenshot unter Ubuntu 15.04.](https://ctaas.de/images/Linux/Unity-web.png)

- die Entwicklung wurde ab Ubuntu 17.10 eingestellt (für Ubuntu wird wieder Gnome verwendet),

- Unity wurde speziell für kleinere Displays wie z. B. Netbooks entwickelt,

- Die Arbeitsumgebung Unity wird hauptsächlich unter Ubuntu eingesetzt,

- des Weiteren werden die Standard GTK+ Programme verwendet,

- Ab Unity 8 wird das Qt-Framework verwendet,

- die linke Schnellstart-

leiste ist clever und auch gut über eine Tastensteuerung zu erreichen,

- auch die Suchfunktion über die [Windows-Fahnentaste] ist an sich gut gelöst,

- nur leider trüben der enorme Ressourcenbedarf, die teileweise übertriebenen Anpassungen mit Themes, sowie die integrierte Websuche (über verschiedenste Portale und die daraus resultierenden Datenschutzprobleme) das positive Bild,

- Unity ist derzeit unter Debian nicht oder nur schwer installierbar.

Folgendes installiert unter Ubuntu den Ubuntu-Desktop mit Unity (weniger empfohlen):

apt-get install ubuntu-desktop

Folgendes installiert die mit Lernprogrammen erweiterte Schulversion Edubuntu (weniger empfohlen):

apt-get install edubuntu-desktop

Tastenkürzel:

Strg+Alt+T = neues Terminal.

SUPER (Windows-Taste)+A = Suche nach Anwendungen.

SUPER (Windows-Taste)+F = Suche nach Dateien (Files).

|

![Screenshot: xorg kde-plasma-deskop + kde-l10n + fonts-croscore [KDE-Plasma 4] unter Debian 8. Ansicht vergrößern über klick oder zoom. KDE Plasma 4 Screenshot unter Debian 8.](https://ctaas.de/images/Linux/KDE-Plasma_4-web.png)

KDE Plasma 4:

- wird ständig weiter entwickelt,

- ist relativ verspielt,

- verwendet die Qt-Bibliothek.

'universe' Paketquelle hinzufügen (Optional/ab Ubuntu 18.04):

add-apt-repository universe

Folgendes installiert den KDE Plasma Desktop:

apt-get install xorg kde-plasma-deskop

Sprachpaket für Ubuntu:

apt-get install language-pack-kde-de

Sprachpaket für Debian:

apt-get install kde-l10n-de

weitere Metapakete:

apt-get install kde-standard

apt-get install kde-full

Folgendes installiert den speziell für Ubuntu angepassten Desktop (weniger empfohlen):

apt-get install kubuntu-desktop

![Screenshot: kubuntu-desktop + fonts-croscore [KDE-Plasma 5] unter Ubuntu 15.04. Ansicht vergrößern über klick oder zoom. KDE Plasma 5 Screenshot unter Ubuntu 15.04.](https://ctaas.de/images/Linux/KDE-Plasma_5-web.png)

Neu:

KDE Plasma 5:

- hat einen modernen flat Look,

- und fast ein einheitliches Design,

- trotzdem ist es noch sehr verspielt,

- befindet sich z. Z. noch in Entwicklung,

- verwendet das Qt 5 und KDE Framework 5,

- Kubuntu 15.04 verwendet KDE Plasma 5 erstmals als Standard Desktop.

KDE-Plasma 5 Installationsanleitung

für Ubuntu 14.10:

apt-add-repository ppa:kubuntu-ppa/next

apt-get update

apt-get dist-upgrade

apt-get install

kubuntu-plasma5-desktop

plasma-workspace-wallpapers

KDE-Plasma Installationsanleitung

ab Ubuntu 15.04:

apt-get install kubuntu-desktop kde-l10n-de

|

|

circa Ressourcenverbrauch*: |

Xfce:

Download: 92 MB

HD Speicher: +336 MB

HD insgesamt: 1,7 GB

laufende Tasks: 110

belegter RAM: 135 MB

Die Angaben beziehen sich auf das Xfce Grundsystem. |

Mate Desktop Environment:

Download: 125 MB

HD Speicher: +423 MB

HD insgesamt: 1,8 GB

laufende Tasks: 103

belegter RAM: 135 MB |

GNOME Flashback (Metacity):

Download: 309 MB

HD Speicher: +1180 MB

HD insgesamt: 3 GB

laufende Tasks: 149

belegter RAM: 320 MB |

LXDE:

Download: 78 MB

HD Speicher: +288 MB

HD insgesamt: 1,6 GB

laufende Tasks: 107

belegter RAM: 110 MB |

LXQt:

Download: 154 MB

HD Speicher: +486 MB

HD insgesamt: 2,1 GB

laufende Tasks: 112

belegter RAM: 150 MB |

IceWM:

Download: 40 MB

HD Speicher: +136 MB

HD insgesamt: 1,5 GB

laufende Tasks: 87

belegter RAM: 75 MB |

Cinnamon:

Download: 185 MB

HD Speicher: +773 MB

HD insgesamt: 2,7 GB

laufende Tasks: 130

belegter RAM: 260 MB |

Ubuntu (Unity):

Download: 625 MB

HD Speicher: +2306 MB

HD insgesamt: 4,8 GB

laufende Tasks: 155

belegter RAM: 500 MB

Die Angaben beziehen sich auf Ubuntu 15.04. |

KDE-Plasma 4:

Download: 209 MB

HD Speicher: +707 MB

HD insgesamt: 2,9 GB

laufende Tasks: 115

belegter RAM: 360 MB

Die Angaben beziehen sich auf KDE-Plasma 4. |

Hinweise:

Eine parallele Installation von verschiedenen Desktopumgebungen kann zu unerwünschten Effekten führen.

Denn Einstellungen wie Thema, Schriftbild, Panel, Icons usw. können andere vorhandene Desktopumgebungen negativ beeinflussen. Man sollte daher möglichst nur einen Fenstermanager (nur eine Desktopumgebung) installieren.

Um alternative Desktopumgebungen zu testen, kann man auch CD/DVD/USB-Live-Systeme, oder getrennte VM Installationen verwenden.

Das System sollte jetzt in den Grundzügen einsatzbereit sein.

In den nachfolgenden Schritten werden verschiedenste wichtige Programme, Tipps sowie einige Server Dienste vorgestellt.

Beachtet hier nur die Punkte die Ihr benötigt.

6. Die grafische Benutzeroberfläche starten & Autologon:

Hier bitte nur eine Option zum Autologin verwenden.

Die einfache Consolenvariante (links) empfiehlt sich für Einzelplatzsysteme und Server - die Variante mit dem Displaymanager (rechts) sollte man verwenden, wenn man einen Anmeldescreen für mehrere Benutzer benötigt.

| TTY Console Autologin: |

Grafisches Login mit dem Displaymanager: |

Verwendet man 'getty' bzw. 'agetty' für das Autologin auf der Console TTY1, dann kann man sich auf dieser Console nicht mehr abmelden.

Möchte man das System später durch ein exit wieder sperren, so muss man stattdessen 'rungetty' verwenden:

apt-get install rungetty

Tipp vorab: Sollte das System nach dem Neustart in der Console hängen bleiben (das passiert nur bei Falscheingaben), dann meldet man sich einfach über eine andere Console an.

Z. B. über Strg + Alt + F2 an. Hier kann man sich dann normal anmelden und Fehleingaben korrigieren oder auch alles wieder rückgängig machen.

Neu für systemd-Versionen:

Unter Debian (ab Debian 8, 9) bzw.

unter Ubuntu (ab Ubuntu 15.04, 15.10, 16.04, 16.10, 17.04, 17.10, 18.04, 18.10)

muss man folgende Schritte durchführen:

Zuerst folgendes Verzeichnis anlegen:

mkdir -pv /etc/systemd/system/getty@tty1.service.d/

Dann eine neue Datei (*.conf) mit folgendem Inhalt anlegen:

nano /etc/systemd/system/getty@tty1.service.d/autologin.conf

# Hier folgende Zeilen hinzufügen:

[Service]

ExecStart=

ExecStart=-/sbin/agetty --autologin Benutzername tty1

# alternativ mit rungetty:

# ExecStart=-/sbin/rungetty --autologin Benutzername tty1

# Wichtig: Die leere 'ExecStart=' Zeile muss man mit eingeben.

Unter Debian ( init-Version bis Debian 7) muss man folgende Datei editieren:

nano /etc/inittab

# Hier die vorhandene Zeile:

1:2345:respawn:/sbin/getty -8 38400 tty1

# so ändern und speichern:

1:2345:respawn:/sbin/rungetty --autologin Benutzername tty1

Unter Ubuntu ( init-Versionen bis Ubuntu 14.10) muss man folgende Datei editieren:

nano /etc/init/tty1.conf

# Hier die vorhandene Zeile:

exec /sbin/getty -8 38400 tty1

# so ändern und speichern:

exec /sbin/rungetty --autologin Benutzername tty1

Die Desktopumgebung kann man nun wie folgt starten:

startx

Will man anschließend von der Console aus direkt in die grafische Oberfläche starten, so legt man im Homeverzeichnis des Benutzers eine neue Datei an:

nano ~/.bash_profile

# Hier fügt man folgenden Befehl ein:

startx &

# Tipp: Hier an dieser Stelle kann man natürlich auch

# beliebige andere Befehle oder Scripte starten (Linux Autostart).

Dann wird nach dem Autologin anschließend direkt der XServer gestartet, ohne dass man einen Displaymanager benötigt.

Wichtig: Will man später auch über SSH und Putty zugreifen, so sollte man ein [ &] anhängen um den XServer im Hintergrund zu starten.

Denn hängt man das [ &] nicht an, so würde in Putty gleich nach dem Login versuchen den XServer zu starten und dann die Console blockieren. |

Möchte man dagegen direkt in die Desktopumgebung (GUI) starten, so kann man einen Displaymanager verwenden.

Der Displaymanager stellt einen Anmeldbildschirm für verschiedene User bereit.

Empfehlen würde ich folgenden:

apt-get install lightdm lightdm-gtk-greeter

Das Startverhalten (ob z. B. direkt das grafische Login gestartet werden soll) kann man jederzeit wie folgt anpassen:

nano /etc/default/grub

# Hier den vorhandenen Eintrag:

GRUB_CMDLINE_LINUX_DEFAULT=""

# ändern in:

GRUB_CMDLINE_LINUX_DEFAULT="text"

# Parameterbeschreibung:

# Ein leerer Eintrag "" bedeutet, es wird direkt das grafische Login gestartet.

# Der Eintrag "text" bedeutet, es wird nach dem Login das Terminal (die Console) gestartet.

Anschließend muss man noch die grub Einstellungen aktualisieren:

update-grub

Die Änderung wird erst nach einem Neustart übernommen:

reboot

In dem Beispiel oben wird also nicht mehr die GUI - sondern nur noch die Eingabeaufforderung (also das Terminal) gestartet.

LightDM Autologon:

Will das ein bestimmter User am LightDM Displaymanager automatisch anmeldet wird, so muss man nur in der Datei:

mousepad /etc/lightdm/lightdm.conf

# Folgendes hinzufügen:

[SeatDefaults]

autologin-user=Username

# autologin-user-timeout=30

# Der Parameter [autologin-user-timeout=xx] ist optional.

# Angegeben wird hier die Zeitdauer (in Sekunden) die gewartet wird bevor das Autologin stattfindet.

# Meldet sich während dieser Wartezeit ein anderer User an, so wird das Autologin unterbrochen.

# Hat man den Parameter nicht angegeben, so wird der User sofort angemeldet.

Nach der Abmeldung des automatisch angemeldeten Users kommt man wieder in die grafische Login-Maske des Displaymanagers, hier kann sich dann auch ein anderer User anmelden.

Gnome 3 Autologon (ähnlich wie bei LightDM):

mouspad /etc/gdm3/daemon.conf

# Hier dann folgende Werte aktivieren & ändern:

[daemon]

# Enabling automatic login

AutomaticLoginEnable=true

AutomaticLogin=Username

# Alternativ kann das verzögerte Login über die vorhandenen TimedLogin-Einträge vorgenommen werden.

# TimedLoginEnable=true

# TimedLogin=Username

# TimedLoginDelay=10

|

7. Anpassung des Netzwerks:

Hier bitte nur eine Auswahl verfolgen.

Entweder man verwendet den Netzwerkmanager links (bei häufig wechselnden Adressen & WLANs, VPN oder DSL Einwahl) oder man stellt die IP-Adresse fest ein (rechts).

| Netzwerkkonfiguration über Netzwerkmanager (WLAN, VPN, DSL): |

IP-Adresse fest einstellen (Server) bis Ubuntu 17.04: |

Eine Möglichkeit ist es den Netzwerkmanager zu verwenden, um die Netzwerkeinstellungen zu ändern. Der Netzwerkmanager wird verwendet, um Netzwerkeinstellungen mit Hilfe einer Programmoberfläche vorzunehmen.

Zum Beispiel kann man hier WLANs auswählen, VPN oder eine DSL Einwahl konfigurieren oder statische IP-Adressen vergeben.

Will man die Netzwerkeinstellungen anpassen, so empfiehlt es sich den Netzwerkmanager nach zu installieren:

apt-get install network-manager network-manager-gnome network-manager-openvpn-gnome

Hinweis: [network-manager-openvpn-gnome] muss man nur installieren wenn man VPN-Verbindungen mit dem Netzwerkmanager einrichten will.

Zuerst muss man die Konfiguration der Netzwerkkarte hier deaktivieren:

nano /etc/network/interfaces

# This file describes the network interfaces available on your system

# and how to activate them. For more information, see interfaces(5).

source /etc/network/interfaces.d/*

# The loopback network interface

auto lo

iface lo inet loopback

# Das loopback-Netzwerkinterface also Original belassen.

# The primary network interface

# allow-hotplug eth0

# iface eth0 inet dhcp

# Und das Netzwerkinterface der Karten auskommentieren (deaktivieren)

# die man über den Netzwerk-Manager einstellen will.

Gleich im Anschluss muss man dann folgende Konfigurationsdatei editieren (nicht immer nötig):

nano /etc/NetworkManager/NetworkManager.conf

Hier den vorhandenen Eintrag wie folgt ändern:

managed=true

Damit der NetworkManager auch noch im Taskleisten-Tray erscheint (je nach Umgebung vorher testen) muss man noch folgende Datei editieren (nicht immer nötig):

nano /etc/xdg/autostart/nm-applet.desktop

# Und hier in der Zeile:

Exec=

# den Eintrag [nm-applet]

in [dbus-launch nm-applet] ändern.

Die Netzwerkeinstellungen werden erst nach einem Neustart übernommen. |

Die Lösung hier gilt bis Ubuntu 17.04. Ab Ubuntu 17.10/18.04 wird netplan verwendet.

Eine andere Möglichkeit der Netzwerkanpassung besteht durch direktes anpassen der Konfigurationsdateien.

Statische IP-Adresse vergeben:

Die Netzwerk-Konfigurationsdatei öffnen:

nano /etc/network/interfaces

die vorhandene Standardkonfiguration:

# This file describes the network interfaces available on your system

# and how to activate them. For more information, see interfaces(5).

source /etc/network/interfaces.d/*

# The loopback network interface

auto lo

iface lo inet loopback

# The primary network interface

allow-hotplug eth0

iface eth0 inet dhcp

wie folgt ändern (IP-Adressen entsprechend anpassen):

# This file describes the network interfaces available on your system

# and how to activate them. For more information, see interfaces(5).

source /etc/network/interfaces.d/*

# The loopback network interface

auto lo

iface lo inet loopback

# The primary network interface

allow-hotplug eth0

iface eth0 inet static # eth0 ist die Netzwerkschnittstelle. Beachtet dabei,

# dass diese ab Ubuntu 15.10 unterschiedliche Namen tragen kann.

address 192.168.2.100

netmask 255.255.255.0

gateway 192.168.2.1

broadcast 192.168.0.255

network 192.168.0.0

dns-search domain.localnet intern.home # Man kann mehrere Domänennamen/Subdomänen angegeben.

dns-domain domain.localnet

dns-nameservers 192.168.2.1 8.8.8.8 # DNS-Server (Lokal & Internet, hier z. B. der Google DNS-Server).

# Wichtig: Hier kann man einen, oder maximal zwei DNS-Server angeben.

# Lässt man die DNS-Serverangabe weg, so kann es zu verschiedensten Fehlern

# wie [unknown host], [... konnte nicht aufgelöst werden.] kommen.

# Daher sollte man den DNS-Server-Eintrag in der Regel immer mit angeben.

# Im Home-Office sollte dies in der Regel die IP-Adresse des Routers/Gateways sein.

# 8.8.8.8 ist ein freier öffentlicher DNS-Server von google.

hwaddress ether 00:11:22:33:44:55 # Optional die MAC-Adresse ändern (erleichtert ggf. die Netzwerkübersicht).

# Hinweis: Ändert man unter VirtualBox in der VM die MAC-Adresse, dann hat man keinen Netzwerkzugriff mehr.

# Verwendet man VirtualBox, so kann man die MAC-Adresse nur

# über den Menüpunkt [Netzwerk] im [Oracle VM VirtualBox Manager] ändern.

|

| den Netzwerk Interface Namen ändern (optional): |

IP-Adresse fest einstellen (Server) ab Ubuntu 17.10/18.04: |

Ab Ubuntu 15.10 erhalten die Netzwerkschnittstellen neue Interface Namen.

Die Namen orientieren sich dabei unter anderem an der Art des Anschlusses (onboard, PCI-Express, USB, WLAN).

Statt eth0, eth1 heißt der Interface Name der Netzwerkkarte dann z. B. enp0s3, enps21, eno1, wlp3s0 usw.

Insbesondere im Betrieb an- und abschaltbare Netzwerkkarten/Geräte wie z. B. USB-Netzwerkkarten machten eine Anpassung des alten Namenschemas erforderlich.

Für die Namensvergabe ist udev verantwortlich.

Im Allgemeinen empfehle ich die Einstellung nach dem neuen Schema zu belassen.

Falls man den Namen trotzdem ändern will so empfehle ich folgende 2 Varianten.

Ändern kann man den Namen wie folgt:

Variante 1 (empfohlen/Update fest):

folgende Datei neu anlegen/ändern:

nano /etc/udev/rules.d/999-network.rules # Die hohe Nummer sorgt dafür, dass dieser Eintrag bei einem Update bestehen bleibt.

# Hier folgendes in einer Zeile einfügen:

SUBSYSTEM=="net", ACTION=="add", ATTR{address}=="11:22:33:44:55:66", NAME="eth0"

SUBSYSTEM=="net", ACTION=="add", ATTR{address}=="aa:bb:cc:dd:ee:ff", NAME="eth1"

# Hinweise:

# Für jede Netzwerkkarte wird ein separater Eintrag erzeugt.

# Die doppelten Gleichheitszeichen muss man genauso mit übernehmen.

# Die MAC-Adresse muss zur jeweiligen Netzwerkkarte passen.

# Alle Buchstaben der MAC-Adresse muss man klein schreiben (sofern welche vorkommen).

# Den Name kann man dabei beliebig wählen, eth0, eth1 sind nur Vorschläge nach dem alten Schema.

Nach einem Neustart ist die Netzwerkkarte über den neuen Namen erreichbar.

Variante 2 (weniger empfohlen/nicht Update fest):

nano /etc/default/grub

# Hier die folgende Zeile wie folgt ergänzen:

...

GRUB_CMDLINE_LINUX="net.ifnames=0 biosdevname=0"

...

# Beachtet: Bei einem Kernel Update/Grub Update wird diese Einstellung möglicherweise wieder zurückgesetzt.

Anschließend muss man noch die geänderten grub Einstellungen aktualisieren:

update-grub

Wichtig:

Beachten sollte man, dass man bei der dazugehörigen Netzwerkkonfiguration

unter [/etc/netplan/*] bzw. [/etc/network/interfaces] (siehe rechte Spalte)

den Netzwerkinterface-Namen entsprechend angepassen muss.

Hier im Beispiel müsste man dann aus enp0s3 -> eth0 machen.

Nach einem Neustart ist dann die Netzwerkkarte über den neuen Namen erreichbar.

|

Ab Ubuntu 17.10/18.04 wird netplan zur Netzwerkkonfiguration verwendet.

Mit netplan sind vielfältige Konfigurationsvarianten möglich.

Unter anderem wird dhcp, static-ip, wakeonlan, routen, bridges, wifi (mit Passwortangabe) und vieles mehr unterstützt.

Eine statische IPv4-Adresse richtet man wie folgt ein:

In das Konfigurationsverzeichnis wechseln:

cd /etc/netplan

Alle Netzwerkkonfigurationen auflisten:

ls -laF

Beachtet dabei, der Konfigurationsname kann verschieden sein, auch mehrere Konfigurationsdateien sind möglich. Legt man mehrere Konfigurationen an, so werden diese in lexikalischer Reihenfolge (0-9 & A-Z) eingelesen.

# Zu Beginn ist oft nur eine einzelne yaml-Konfigurationsdatei zur Netzwerkkonfiguration vorhanden.

# Diese sollte man öffnen:

nano 01-netcfg.yaml # Den Dateinamen ggf. anpassen.

nano /etc/netplan/* # Oder wenn es nur eine Konfiguration gibt, diese direkt öffnen.

die vorhandene Standardkonfiguration:

# This file describes the network interfaces available on your system

# For more information, see netplan(5).

network:

version: 2

renderer: networkd

ethernets:

enp0s3: # Beachtet der Interface-Name der Netzwerkkarte ist Geräteabhängig/verschieden.

dhcp4: yes

dhcp6: yes

wie folgt ändern (IP-Adressen entsprechend anpassen):

# This file describes the network interfaces available on your system

# For more information, see netplan(5).

network:

version: 2

ethernets:

enp0s3: # Den Interface-Name der Netzwerkkarte muss man entsprechend übernehmen.

dhcp4: no # Den automatischen Bezug von IPv4-Adressen ausschalten.

# dhcp6: no # Den automatischen Bezug von IPv6-Adressen ausschalten (APIPA Adresse).

addresses: [192.168.2.100/24] # statische IPv4-Adresse und Subnetzmaske.

gateway4: 192.168.2.1 # Standardgateway, meist die DSL-Router IP-Adresse.

nameservers:

addresses: [192.168.2.1, 1.1.1.1, 9.9.9.9, 8.8.8.8] # DNS-Server Lokal & Internet.

# Parametererklärungen:

# IP-Adresse und Subnetzmaske:

# 192.168.2.100 = ist die feste IP-Adresse die man vergeben will.

# /24 = bestimmt die Subnetmaske (3 Bytes * 8 Bits = 24 Bits = 255.255.255.0).

# DNS-Server Adressen:

# 192.168.2.1 = ist hier Beispielsweise ein lokaler DNS-Server. Beachtet dabei, ein

# DSL-Router verwendet in der Regel nur einen DNS-forwarder über das Standardgateway.

# Die IP-Adresse vom DSL-Router sollte man daher hier nicht angegeben.

# 1.1.1.1 = ist der freie DNS-Server von CloudFare + APNIC.

# 9.9.9.9 = ist der freie DNS-Server von Global Cyber Alliance (GCA) + Partner.

# 8.8.8.8 = ist der freie DNS-Server von Google.

# Wichtiges:

# Die Konfiguration darf keine Tabulator-Zeichen enthalten.

# Zum Einrücken sind nur Leerzeichen erlaubt. Wenn man doch Tabs verwendet hat, dann

# erhält man den Fehler: [ Invalid YAML at ... found character that cannot start any token].

# Wenn die Einrückung nicht stimmt dann erhält man den Fehler:

# [ Invalid YAML at /etc/netplan/ ... mapping values are not allowed in this context]

# Beachtet hier folgendes:

# Alle Schlüssel muss man mit Leerzeichen wie oben dargestellt nach rechts einrücken.

# Dies ist notwendig, damit das System die Schlüssel korrekt zuordnen kann.

# Hier noch ein Beispiel. 'addresses' gibt es z. B. zweimal.

# Der erste 'addresses' Schlüssel bezieht sich auf die Netzwerkkarte (hier enp0s3),

# dieser bestimmt die IP-Adresse der Netzwerkkarte.

# Der zweite 'addresses' Schlüssel bezieht sich auf 'nameservers',

# dieser gibt hier die Adresse(n) zum DNS-Server an.

# Damit das System die doppelten Werte korrekt zuordnet, muss man diese entsprechend einrücken.

# Man erhält den Fehler: [ Error in network definition /etc/netplan/ ... unknown key adresses],

# wenn man die Schlüssel also den Teil links vor dem Doppelpunkt falsch geschrieben hat.

# Man erhält den Fehler: [ Error in network definition /etc/netplan ... expected sequence],

# wenn man die eckigen Klammern [ ] bei Schlüsseln mit mehreren Werten nicht vorhanden sind.

# Beachtet auch, zu den angezeigten fehlerhaften Zeilen (line) und Spaltennummern (column)

# muss man in der Regel immer eins (+1) dazu addieren.

Die neuen Einstellungen werden bei einem Neustart automatisch übernommen.

Mit folgendem Befehl kann man die Änderungen sofort prüfen und übernehmen:

netplan apply

Eventuelle Fehler werden sofort angezeigt.

Wird nach Eingabe des Befehls nichts angezeigt, dann ist alles ok.

Für debug Zwecke kann man folgenden Befehl verwenden:

netplan --debug apply

Hier sieht man dann mehr Details, so kann man ggf. Fehler leichter finden und beheben.

Aufruf der Hilfe mit:

man netplan

Von der Konfigurationsdatei sollte man vor der Bearbeitung eine Sicherung anlegen.

Da netplan nur *.yaml Dateien verarbeitet, empfehle ich das Anhängen des Datums.

Beispielsweise so (Dateiname & Pfad entsprechend anpassen):

cp 01-netcfg.yaml 01-netcfg.yaml.2018-06-05

Hierzu noch folgende kurze Anmerkungen:

Man sollte sich bevorzugt mit dem neuen Schema befassen (das ist Zukunftssicher).

Ich empfehle daher nicht auf das alte Schema umzuschalten (auch das wäre möglich).

Vor allem sollte man niemals alte Konfigurationen (/etc/network/interfaces) und

neue netplan Konfigurationen (/etc/netplan/*) zur gleichen Zeit verwenden.

Um Problemen aus dem Weg zugehen solltet ihr hier nur einen Weg nutzen.

Ich persönlich würde ab Ubuntu 17.10/18.04 die neuen Einstellungen über netplan nutzen. |

Tipps zum Netzwerk:

Änderungen am Netzwerk werden erst übernommen wenn man das Netzwerk neu startet.

ip -c a = Zeigt die derzeitige Netzwerkkonfiguration farblich hervorgehoben an.

ip link = Zeigt die MTU Einstellung und MAC-Adressen an.

ifconfig -a = Zeigt die derzeitige eingestellte Konfiguration an.

networkctl status -a = Status-Anzeige der verwendeten Netzwerklinks.

ifup eth0 = startet das Netzwerk eth0.

ifdown eth0 = beendet das Netzwerk eth0.

ping 192.168.2.1 = setzt Ping Pakete an die Adresse 192.168.2.1 ab.

netstat -npl = Zeigt Aktive Internetverbindungen, Sockets und die verwendeten Ports an.

netstat -s = Zeigt verschiedene Paketstatistiken an.

apt-get install traceroute = Installiert das Linux Pendant zum Windows Befehl [tracert]

um Routen zu verfolgen [traceroute IP oder Hostname].

/etc/hostname = die Datei enthält den Hostnamen des eigenen Systems.

/etc/hosts = in der Datei kann man IP-Adressen und Domain-Namen sowie lokale PC-Namen zuweisen (auch für Werbeblocker geeignet).

8. hosts-Datei/WINS/NetBIOS Hostnamen auflösen (winbind):

Wichtig in kleinen Netzwerken:

Wenn man keinen eigenen DNS-Server eingerichtet hat (also nur einen Standard DSL-Router verwendet), dann macht der Router nicht automatisch eine Namensauflösung,

denn der Router leitet die Namens-Anfragen nur an die vom Provider bereitgestellten DNS-Server im Internet weiter.

Diese DNS-Server im Internet kennen jedoch die PCs und Geräte im LAN nicht und eine Namensauflösung schlägt fehl.

Daher kann der Router diese Hostnamen nicht auflösen.

Um das Problem zu lösen installiert man entweder einen DNS-Server (wie z. B. bind9) oder einen WINS-Server (der Windows Internet Name Service (WINS) übernimmt die Namensauflösung von NetBIOS-Computernamen).

Am einfachsten installiert man den [samba nameservice integration server] (winbind):

apt-get install winbind

Danach muss man nur noch folgende Konfigurationsdatei anpassen:

nano /etc/nsswitch.conf

# Hier ändert man die Zeile hosts: wie folgt ab:

...

hosts: files wins dns

...

Parameterbeschreibung:

Die Hostnamenauflösung aller Netzwerkgeräte (PCs, Drucker, Tablet ...) sollte damit sofort klappen.

Denn winbind dient der Integration von Namensdiensten für Samba-Server und erledigt das Auflösen von Benutzer-/Gruppeninformation für Microsoft Windows, OS X, und andere Unix-Systeme.

Die Reihenfolge der Abfragen kann man beliebig festlegen:

[files] steht für die Abfrage über die [/etc/hosts]-Datei.

[wins] steht für die Abfrage über den WINS-Server.

Wenn kein WINS-Server im Netzwerk vorhanden ist geschieht die WINS-Namensauflösung über NetBIOS-Broadcast.

Das bedeutet nichts anderes, als dass ein Computer, der einen Hostnamen im Netz auflösen möchte, einen Broadcast (Rundruf) ins lokale Netzwerk (an alle im Subnetz) sendet und so den angesprochenen Empfänger auffordert mit seiner

IPv4-Adresse (WINS ist nicht IPv6 kompatibel) zu antworten. Auf Grund wie diese Informationen über das Netzwerk übermittelt werden kann dies ggf. ein Sicherheitsrisiko darstellen (wenn kein Zentraler Server vorhanden ist).

WINS beantwortet nur Antworten aus dem eigenen Subnetz - Routen in andere Netze schlagen daher oft fehl.

NetBIOS-Namen (Hostnamen) dürfen maximal nur 15 Zeichen lang sein.

[dns] steht für die Abfrage über den DNS-Server.

Die [winbind]-Installation behebt also typische Namensauflösungsfehler wie z. B.: [ping: unknown host] (ping),

[server can't find ... : NXDOMAIN] (nslookup), [... : Der Name oder Dienst ist nicht bekannt] (traceroute).

Alternativen:

Will man nicht noch einen extra Daemon laufen lassen, so kann man Hostnamen auch über die [hosts]-Datei bekannt machen:

nano /etc/hosts

9. Netzwerk browsing aktivieren:

Kann man das Netzwerk nicht nach (Windows) Freigaben durchsuchen, so muss man folgendes Paket nachinstallieren:

apt-get install gvfs-backends

Dieses ermöglicht das Einhängen von virtuellen Dateisystemen, also das Einhängen von verschiedensten Freigaben (wie z. B. ftp, http, network, sftp, smb, smb-browse, usw.).

10. Empfehlenswerte Zusatzprogramme:

Da einige Minimalinstallationen sehr spartanisch daher kommen, hier noch ein paar empfohlene/wichtige Programme die man je nach Bedarf nach installieren kann.

Einträge die mit Sternen gekennzeichnet wurden sind meine persönliche Bewertung (mehr Sterne [*] = besser - bewertet wurde der Funktions- und Bedienungsumfang).

Einträge die mit einem Herzen [♥] gekennzeichnet wurden sind meine besonderen Empfehlungen.

Am Ende ist bei einigen Programmen in Klammern die jeweils dazugehörige Standard Systemumgebung angegeben.

Natürlich kann man die Programme unter jeder beliebigen Distribution installieren.

apt-get install update-manager - installiert ein Programm um System-Updates zu installieren (für alle auf Ubuntu basierende Systeme).

apt-get install pcmanfm - ** installiert einen Dateimanager (LXDE).

apt-get install gnome-system-monitor - ** installiert einen Taskmanager, der unter anderem den CPU- und RAM-Verbrauch sowie Netzwerk-Traffic anzeigen kann (Gnome).

apt-get install mate-system-monitor - installiert einen Taskmanager, der unter anderem den CPU- und RAM-Verbrauch sowie Netzwerk-Traffic anzeigen kann (MATE).

apt-get install xfce4-taskmanager - * installiert einen einfachen Taskmanager, der unter anderem den CPU- und RAM-Verbrauch anzeigen kann (Xfce).

apt-get install lxtask - installiert einen einfachen Taskmanager, der unter anderem den CPU- und RAM-Verbrauch anzeigen kann (LXDE).

apt-get install mousepad - **♥ einen Text Editor mit Syntaxhervorhebung installieren (Xfce).

apt-get install pluma - ***♥ installiert einen Text Editor mit Syntaxhervorhebung und Plugin-Optionen -

wie z. B. eine Rechtschreibprüfung [apt-get install hunspell-de-de] (MATE).

apt-get install leafpad - einen Text Editor installieren (LXDE).

apt-get install synaptic - eine grafische Paketverwaltung installieren.

apt-get install xfce4-terminal - **♥ installiert ein Terminal, in dem man auch eigene Fonts verwenden kann (Xfce).

apt-get install lxterminal - installiert ein Terminal, in dem man auch eigene Fonts verwenden kann (LXDE).

apt-get install virtualbox-guest-x11 - die VirtualBox Gasterweiterungen installieren. Optionale Pakete [virtualbox-guest-dkms] & [virtualbox-guest-utils].

apt-get install firefox firefox-locale-de - installiert den Webbrowser Firefox.

apt-get install iceweasel iceweasel-l10n-de - installiert den auf Firefox basierenden Webbrowser unter Debian.

apt-get install chromium-browser chromium-browser-l10n chromium-codecs-ffmpeg chromium-codecs-ffmpeg-extra - installiert Google Chrome, mit Multimedia-Codecs, wie z. B. AAC/AC3/MPEG-4 Audio/H264/QuickTime/MP3.

apt-get install chromium chromium-l10n - installiert Google Chrome unter Debian.

apt-get install thunderbird thunderbird-locale-de - installiert das E-Mailprogramm Thunderbird unter Ubuntu.

apt-get install icedove icedove-l10n-de - installiert ein E-Mailprogramm (basiert auf Thunderbird) unter Debian.

apt-get install midori - installiert einen schlanken Webbrowser (Xfce4).

apt-get install fonts-croscore - ♥ installiert den Monospace Font 'Cousine' (bei Debian erst ab Version 8 verfügbar) z. B. fürs Terminal.

apt-get install xfonts-terminus - installiert den Terminus Font z. B. fürs Terminal.

apt-get install language-pack-gnome-de - installiert fehlende Sprachpakete nach (Gnome).

apt-get install language-pack-de - installiert fehlende Sprachpakete nach (Metapaket für Systemanwendungen).

apt-get install oxygen-icon-theme - installiert ein alternatives Icon-Thema.

apt-get install xarchiver - installiert einen Packer (Xfce).

apt-get install Xfburn - installiert eine Brennsoftware (Xfce).

apt-get install brasero - * installiert eine Brennsoftware die unter anderem auch CD/DVD kopieren kann (auch als Image).

apt-get install lxmusic - installiert einen einfachen Musikplayer (LXDE).

apt-get install vlc - * installiert den VLC media player von VideoLAN.org (vlc startet ggf. nicht wenn man als root-User angemeldet ist).

apt-get install parole - installiert einen schlanken Videoplayer (Xfce4).

apt-get install gpicview - ** installiert einen Bildbetrachter (LXDE).

apt-get install ristretto - * installiert einen Bildbetrachter (Xfce4).

apt-get install eom - installiert den Bildbetrachter Eye-of-Mate (MATE).

apt-get install xfce4-whiskermenu-plugin - installiert unter Xfce ein schlichtes alternatives Startmenü (dieses kann man dann der Leiste hinzufügen).

Funktionen wie: Favoriten, Gliederung der Anwendungen, Anzeige der zuletzt genutzten Programme, oder eine Suchfunktion werden hier bereitgestellt.

apt-get install adblock-plus - installiert einen Werbefilter für den Webbrowser.

apt-get install warmux supertux pingus monkey-bubble tecnoballz lbreakout2- installiert folgende Games: einen Worms Clone, ein Jump'n'Run,

ein Lemmings-Clone, ein Bubble-Spiel und zwei Breakout's Clones. Die gelb hervorgehobenen laufen unter einer VM eher schlecht.

apt-get install ubuntu-restricted-extras - installiert unfreie Code-Plugins unter anderem gstreamer, ffmpeg, adobe-flashplugin und MS-Fonts (Ubuntu).

apt-get install flashplugin-nonfree installiert den Adobe Flashplayer - unter Umständen muss die [Multiverse]-Paketquelle hinzufügen.

apt-get install openjdk-9-jdk openjdk-9-source openjdk-9-demo openjdk-9-doc openjdk-9-jre-headless - installiert das Java-Development-Kit (für Entwickler).

apt-get install openjdk-*-jre icedtea-*-plugin - installiert immer die aktuelle Java Version incl. Webbrowser-Plugin.

Hinweis: Setzt man statt der Versionsnummer den Joker '*' ein, so wird immer automatisch die aktuelleste Version ausgewählt.

apt-get install compizconfig-settings-manager compiz-plugins-extra - (universe) erweiterte Effekte (wie einen 3D-Desktop, abbrennende-, wabbelnde- und explodierende-Fenster uvm.)

nachrüsten (Ubuntu). [ccsm] startet den 'CompizConfig Einstellungs-Manager', alle geänderten Einstellungen werden im Ordner [~/.gconf/] gespeichert.

Bei Fehlern sollte man diesen Ordner löschen und neu starten.

apt-get install p7zip-full - installiert den Packer 7-zip.org [7z].

apt-get install ntfs-3g - Lese- und Schreibzugriff für NTFS-Dateisysteme nachrüsten (nur Debian/unter Ubuntu bereits integriert). In aktuellen Live-Systemen ist dies meist schon installiert.

apt-get install hardinfo sysinfo lshw lshw-gtk - installiert verschiedene Tools um Hardware-Infos an zu zeigen (für Console & XServer).

apt-get install gsmartcontrol smartmontools - installiert Tools um SMART-Werte (Self-Monitoring, Analysis, and Reporting Technology)

von SSDs & HDs anzuzeigen & zu überwachen [smartctl -a /dev/sda].

apt-get install libreoffice libreoffice-l10n-de libreoffice-help-de - installiert das komplette LibreOffice.

apt-get install gimp gimp-help-de - installiert GIMP2.

apt-get install testdisk - sucht und repariert gelöschte Partitionstabellen (Hinweis: testdisk stellt den MBR nicht wieder her).

Alternativ kann man zum Partitionen wieder herstellen [gpart -g -i -W /dev/sda /dev/sda] verwenden - gpart unterstützt zurzeit allerdings kein ext3 & ext4.

apt-get install qpdfview - Installiert einen PDF-Viewer.

11. Paketquellen entfernen:

Will man Programme nachinstallieren, so wird unter Debian oft nach der Installations-CD/DVD gefragt.

Hat man diese nicht mehr zur Hand, oder will man aus Bequemlichkeit lieber die Online-Quellen verwenden,

so kann man diese einfach auskommentieren. Öffnet hierzu die Datei:

nano /etc/apt/sources.list

# Hier ändert man alle Einträge, die den Eintrag [cdrom:] enthalten:

deb cdrom: [...] / ... main

# so ab:

# deb cdrom: [...] / ... main

# Man fügt also vor die Entsprechenden Zeilen ein Rautezeichen [#] ein.

# Das Rautezeichen bewirkt, dass diese Zeilen nicht mehr ausgewertet wird.

12. TTY Terminal Consolen Font ändern & Tipps zur Console:

Damit mehr in der in den Consolen (Strg + Alt und F1 bis F7) angezeigt wird, kann man einen anderen Font auswählen:

dpkg-reconfigure console-setup

Hier wählt man dann z. B. folgendes:

UTF-8

# Latin1 und Latin5 - ...

Terminus (optional TerminusBold oder Fixed)

8x14

Danach haben die Terminals z. B. 28 statt 25 Zeilen.

Möglichkeit 2 bzw. Workaround falls die Einstellungen nach einem Neustart nicht übernommen werden:

Unter Ubuntu 15.04/Ubuntu 15.10 wird die Einstellung von [dpkg-reconfigure console-setup] nach einem Neustart vergessen (bug?).

Man kann hier einfach in der Datei:

nano /etc/rc.local

# Hier vor dem Eintrag [exit 0] eine den entsprechenden Fontaufruf hinzufügen (hier 2 Vorschläge):

/bin/setfont /usr/share/consolefonts/Lat7-Terminus14.psf.gz

/bin/setfont /usr/share/consolefonts/Lat7-Fixed13.psf.gz

# Weitere Fonts und Größen findet man im Verzeichnis [/usr/share/consolefonts/].

Tipps zum Terminal/zur Console:

Seitenweises scrollen im Terminal über Shift + Bild auf bzw. Shift + Bild ab.

Strg + r die letzten Befehlseingaben durchsuchen.

Strg + a Cursor an Zeilenanfang setzen.

Strg + e Cursor an Zeilenende setzen.

Strg + u Zeileninhalt löschen.

Strg + Shift + v etwas im Terminal einfügen (anders als zum Beispiel in Windows).

Die Terminal/Consolen Historie löschen:

Gespeichert wird die Historie in einer versteckten Text-Datei mit dem Namen [.bash_history], in der Regel liegt die Datei direkt im entsprechenden Userprofil.

Hierzu vorab noch folgender Tipp: Beginnt man den Kommandozeilenbefehl mit einem Leerzeichen, so wird dieser nicht in der Historie gespeichert.

Den Historie-Cache löschen:

history -cw

Parameterbeschreibung:

[-c] = (clear) löscht die Historie.

[-w] = (write) schreibt die [.bash_history]-Datei neu.

[-cw] = löscht also die Historie & speichert diese sofort (leer) ab.

Man kann die History auch löschen in dem man die History-Datei selbst löscht.

rm ~/.bash_history

Da sich ggf. noch eine Kopie der History im RAM befindet, muss man im Anschluss noch alle Terminals schließen - dann sollte die History leer sein.

13. Grafische Fernsteuerung/Fernwartung der Server:

Die Vorgestellten Lösungen sind eine Auswahl, diese wurden getestet und für gut befunden.

Es gibt natürlich noch eine Vielzahl anderer Möglichkeiten zur Fernsteuerung. Hier sollte man sich also je nach Bedarf die benötigte Verbindung heraussuchen.

| xrdp (RDP): |

vino (VNC): |

x11vnc (VNC): |

Um von Windows aus auf den Desktop zu zugreifen installiert man am einfachsten den xrdp Server (Remote Desktop Protokoll)

(sourceforge.net/projects/xrdp, xrdp.org):

apt-get install xrdp

Anpassungen unter:

mousepad /etc/xrdp/xrdp.ini

xrdp erzeugt neue virtuelle X-Sitzungen, teilweise stimmten hier bei mir die Pfade nicht, so dass bei mir z. B. Installationen nicht klappten. |

Den VNC Server installieren:

apt-get install vino

Passwort und Einstellungen festlegen:

vino-preferences

vino-passwd

VNC Serverstart über:

/usr/lib/vino/vino-server

Problemlösung falls es nicht klappt (Verschlüsselung ausschalten):

apt-get install dconf-editor

Den Editor starten:

dconf-editor

Hier unter [org] >[gnome] > [desktop] > [applications] > [remote-access],

bei [require-encryption] den [ ] Haken entfernen.

Wenn man will kann man hier auch einen [view-only] Modus aktivieren.

Hinweis: Achtung die Tastaturbelegung ist US nicht DE. |

Der x11vnc Server gefällt mir persönlich derzeit am besten, denn x11vnc gibt 1:1 den tatsächlichen Bildschirminhalt wieder.

x11vnc Installieren über:

apt-get install x11vnc

Starten kann man den Server (ohne Passwortabfrage) über:

x11vnc

Beim Starten sollte man die angezeigte Portadresse beobachten.

Zunächst sollte man ein Passwort festlegen (mit eigenem Pfad zur Passwortdatei):

x11vnc -storepasswd P@ssw0rD /etc/x11vnc.pass

Man sollte diese Datei auch für andere lesbar machen (so das auch Standard-User eine VNC-Verbindung aufbauen können):

chmod 644 /etc/x11vnc.pass

Den Server kann man jetzt mit Passwortabfrage starten (mit eigenem Pfad zur Passwortdatei) einmaliger Verbindungsaufbau:

x11vnc -rfbauth /etc/x11vnc.pass

Alternativ kann man das Passwort auch über die Terminal Zeile eingeben:

Das Passwort wird hierbei im Terminal abgefragt und automatisch verschlüsselt in der Datei ~/.vnc/passwd im User-Home-Dir gespeichert.

x11vnc -storepasswd

Der Server wird dann so gestartet (es wird hierbei dann die oben angelegte ~/.vnc/passwd Passwortdatei aus dem User-Home-Dir verwendet.):

x11vnc -usepw

Den Server mit einem bestimmten Port starten:

x11vnc -rfbport 5900

Den Server für einen dauerhaften Verbindungsaufbau bereit machen:

x11vnc -forever

Natürlich kann man die Parameter auch zusammen verwenden:

x11vnc -rfbauth /etc/x11vnc.pass -forever

-rfbport 5900 &

VNC Tastaturlayout auf Deutsch umstellen:

Unter Xfce wird das Tastaturlayout nicht übernommen.

Beheben kann man das Problem in dem man die Spracheinstellung fest auf die gewünschte Sprache einstellt.

Hierzu muss man unter [Einstellungen]

> [Einstellungen] > [Tastatur] > [Tastaturbelegung]

den [ ] Haken bei [Systemweite Einstellungen benutzen] entfernen.

Der Verbindungsaufbau vom Client aus erfolgt dann über IP-Adresse und Portangabe, also z. B. so:

192.168.2.1:5900 |

Sicherheitshinweise:

RDP-Verbindungen verwenden nur eine RC4-Verschlüsselung - diese gilt als nicht mehr 100 % sicher.

Auch VNC-Verbindungen sind nicht verschlüsselt, es werden z. B. Tastatureingaben im Klartext übertragen!

Es besteht daher die Gefahr, das Übertragungen belauscht und Passworte mitgeschnitten werden.

Man sollte daher RDP- und VNC-Verbindungen nur Netzintern bzw. abgesichert über ein VPN oder einen anderen gesicherten Tunnel verwenden.

Will man auf die Systeme gesichert (über das Internet) zugreifen, so empfiehlt sich die Nutzung von SSH (siehe Punkt 15).

14. vsftpd FTP-Server mit Benutzeranmeldung (FTP/FTPS):

vsftpd ist ein FTP-Server der auf besondere Sicherheit ausgelegt wurde (Very Secure File Transfer Protocol Daemon).

vsftpd ist schnell, stabil und sicher und wird bei den meisten Distributionen regelmäßig gepflegt und mit Sicherheitsupdates versorgt.

Daher würde ich vsftpd bevorzugt empfehlen.

Links: Original Webseite - vsftpd.conf Parametererklärungen

| vsftpd Grundkonfiguration & Benutzerkonfiguration: |

Absicherung mit Zertifikaten (FTPS-Server): |

Den FTP-Server installieren:

apt-get install vsftpd

Anschließend muss man Konfigurationsdatei öffnen:

nano /etc/vsftpd.conf

# Hier folgende Zeilen am Anfang hinzufügen:

userlist_deny=NO # Die Anmeldungen von allen lokalen Usern verbieten (erhöht die Sicherheit).

userlist_enable=YES # Ausgenommen sind nur lokale User die auf der unter [userlist_file] geführten Liste stehen.

userlist_file=/etc/vsftpd.user_list

# Optional: Die Datei wird geladen wenn [user_list] auf [YES] steht (Standard ist /etc/vsftpd.user_list).

local_root=/srv/ftp # In diesen Pfad wird nach einem Userlogin gewechselt. Hier müssen dann die bereitgestellten FTP-Daten hin.

# Und folgende vorhandene Zeilen ändern:

anonymous_enable=NO # Auf [NO] umändern = Anonymen Zugang nicht gestatten.

local_enable=YES # Das Rautezeichen [#] Am Anfang entfernen. Lokalen Benutzern den Login gestatten.

xferlog_enable=YES # Optionales Logging (Standard=YES). Kann man später auch ausschalten.

connect_from_port_20=NO # Auf [NO] umändern. Der Port 21 reicht in der Regel völlig aus.

ftpd_banner=Willkommen # Optional: Eigene Willkommensmeldung für FTP Gäste.

dirmessage_enable=YES # Anzeigen von [.message] Dateien.

use_localtime=NO # Optional: Wenn die Zeit im FTP abweicht auf [NO] stellen (war bei mir in VMs so).

chroot_local_user=YES # Hier das Rautezeichen [#] Am Anfang entfernen.

# Lokale Benutzer auf das Home Verzeichnis (definiert unter local_root) beschränken (erhöht die Sicherheit).

# Achtung den Eintrag gibt es zweimal, einen aktivieren reicht aus.

listen_port=21 # Optional: Wer mag kann auch den Standard-Port ändern.

# Ein geänderter Port kann auch Angriffe erschweren.

# Will man auf den FTP-Server über das Internet

# zugreifen, so muss man im Router für diesen Port

# eine entsprechende Weiterleitung einrichten.

Will man für Tests vorübergehend nur die Anonyme Anmeldung zulassen, so muss man [userlist_enable=NO]

und [anonymous_enable=YES] setzen, sowie den [vsftpd]-Dienst neu starten.

Als nächstes muss man die User hinzufügen die den FTP-Server besuchen dürfen:

nano /etc/vsftpd.user_list

Hier kann man dann die User hinzufügen denen der FTP-Zugang gewährt wird:

Benutzer1

Benutzer2

...

Wichtig:

Alle Änderungen werden erst nach einem Neustart des FTP-Servers übernommen.

Den Server Neustarten/Starten/Beenden:

service vsftpd restart

/etc/init.d vsftpd start

/etc/init.d vsftpd stop

Ab sofort funktioniert der FTP-Server. Benötigt man einen reinen öffentlichen Downloadserver ist man hier fertig.

Will man Daten hoch laden so muss man noch den Schreibzugriff aktivieren (siehe rechts unten).

Will man den Transfer verschlüsseln, so benötigt man Zertifikate um die Übertragung ab zu sichern (siehe rechts oben).

Willkommens Meldung anlegen (optional):

In den FTP-Bereich wechseln:

cd /srv/ftp/

Eine neue Datei anlegen:

nano .message

# Hier dann eine beliebige Willkommensmeldung eintragen:

Willkommen! Hinweis: Alle Zugriffe werden Protokolliert.

|

Absicherung mit Zertifikaten:

Vorbereitende Arbeiten:

openssl installieren & Verzeichnisse mit Berechtigungen anlegen (meist vorhanden):

apt-get install openssl

mkdir -p /etc/ssl/private

chmod 700 /etc/ssl/private

Das Zertifikat erzeugen:

openssl req -x509 -nodes -days 365 -newkey rsa:8192 -keyout /etc/ssl/private/vsftpd.pem -out /etc/ssl/private/vsftpd.pem

Die nachfolgenden Abfragen entsprechend ausfüllen:

Country Name ... = DE

State or Provice ... = Bundesland

Locality Name (eg, city) = Stadt

Organization Name ... = Firmenname

Organization Unit ... = Abteilung

Common Name ... = Domainname.de

Email Address ... = E-Mailadresse

Aus dem eben erzeugten Zertifikat extrahiert man den Privat-Key:

openssl rsa -in /etc/ssl/private/vsftpd.pem -out /etc/ssl/private/vsftpd.key

Anschließend muss man die Konfiguration wie folgt ergänzen:

nano /etc/vsftpd.conf

# folgende Zeilen am Anfang hinzufügen:

force_local_data_ssl=YES

force_local_logins_ssl=YES

ssl_ciphers=HIGH

# und folgende vorhandene Zeilen ändern:

rsa_cert_file=/etc/ssl/private/vsftpd.pem

rsa_private_key_file=/etc/ssl/private/vsftpd.key

ssl_enable=YES

# Folgende Einträge braucht man nicht hinzufügen,

# da diese im Default/Standardmäßig schon die richtigen Werte haben:

ssl_tlsv1=YES # Standard=YES

ssl_sslv2=NO # Standard=NO

ssl_sslv3=NO # Standard=NO

allow_anon_ssl=NO # Standard = NO

# Disable SSL session reuse:

# ist nur nötig bei wenigen speziellen Clients

# wie z. B. bei FireFTP.

# Diesen Wert daher nur einstellen,

# wenn dies wirklich benötigt wird.

# require_ssl_reuse=NO

Hinweis: Setzt man [force_local_logins_ssl=NO] und [force_local_data_ssl=NO],

so werden sowohl TLS (verschlüsselte Verbindungen mit Zertifikat) als auch nicht-TLS Verbindungen (unverschlüsselte Verbindungen) erlaubt, je nach dem was der FTP-Client unterstützt.

|

| einen reinen FTP-User anlegen (optional): |

Schreibzugriff aktivieren: |

Empfehlenswert ist es wenn man einen reinen FTP-Benutzer anlegt, der sich nicht am lokalen System anmelden kann.

Sinn und Zweck: Dies erhöht die Sicherheit des Systems bei möglichen Angriffen.

Den neuen FTP-Benutzer anlegen:

useradd usr_ftp_only -m -d /home/usr_ftp_only -s /bin/false

Parameterbeschreibung:

[usr_ftp_only] ist der Benutzername des neu anzulegenden Users, der Name ist natürlich frei wählbar.

[-m] (main) ist die Kurzform von [--create-home] > bedeutet: Beim Erstellen wird das Home-Verzeichnis mit erstellt.

[-d] (dir) ist die Kurzform von [--home] > bedeutet: Hier wird der Pfad zum Home-Verzeichnis festgelegt (ggf. ändern).

[-s] ist die Kurzform von [--shell] > bedeutet: legt die zu startende login shell fest.

Für den eben erzeugten User muss man noch ein Passwort vergeben:

passwd usr_ftp_only

Nun muss man noch die login shell (/bin/false) hinzufügen:

nano /etc/shells

hier also am Ende folgendes hinzufügen:

/bin/false

Ebenso sollte man nicht vergessen den User in der [vsftpd.user_list] einzutragen:

nano /etc/vsftpd.user_list

Den eben angelegten User hinzufügen (andere User ggf. löschen):

usr_ftp_only

|

Die Konfigurationsdatei öffnen:

nano /etc/vsftpd.conf

# und folgende Einträge anpassen:

write_enable=YES # Die Dateirechte (chmod) muss man ebenfalls setzen.

local_umask=022

und folgendes hinzufügen:

allow_writeable_chroot=YES # Falls man direkt ins FTP-Wurzelverzeichnis (FTP root Verzeichnis) schreiben will.

Will man nur einigen Usern das schreiben ins FTP-Wurzelverzeichnis (ins FTP root Verzeichnis) erlauben,

so sollte man sich die Einträge [chroot_local_users=YES], [chroot_list_enable=YES] und [chroot_list_file=/etc/vsftpd.chroot_list] genauer anschauen.

vsftpd erlaubt es Standardmäßig nicht das man direkt ins Wurzelverzeichnis des FTP-Servers (local-root=/srv/ftp) schreiben kann (es sei denn man hat dies durch [allow_writeable_chroot=YES] explizit erlaubt).

Am einfachsten umgeht man das Problem, in dem man ein Unterverzeichnis in dem FTP-Verzeichnis erstellt und hier die Schreibrechte erteilt.

mkdir /srv/ftp/net/

chmod 777 /srv/ftp/net/

Wichtige Hinweise & Fehlerbehebungen:

vsftpd ist auf Sicherheit ausgelegt und überprüft vor dem Start seine eigene Konfiguration und die Rechte aller Dateien auf die es zugreifen soll und verweigert den Start bzw. den Zugriff bei einer eventuell

falschen Konfiguration (siehe auch die FAQ auf der Herstellerwebseite). Hat man die Dateiberechtigung vom FTP-Wurzelverzeichnis (local-root=/srv/ftp) geändert, so kommen möglicherweise Fehler

wie [GnuTLS-Fehler -15: An unexpected TLS packet was received.] oder [Herstellen der Verbindung zum Server fehlgeschlagen].

Als Lösung hilft hier nur die original Berechtigungen wieder herstellen [chmod 755 /srv/ftp] und [chown root:ftp /srv/ftp]

oder man lockert die Sicherheitsbestimmungen durch Hinzufügen von [allow_writeable_chroot=YES].

Versucht man in die FTP-root zu schreiben kommen möglicherweise Fehler wie:

[553 Could not create file.], [Kritischer Dateiübertragungsfehler] oder [550 Create directory operation failed.].

Als Lösung hilft hier nur wie oben beschrieben 1. ein Unterverzeichnis anlegen und 2. die entsprechende Berechtigung zu vergeben oder man lockert die Sicherheitsbestimmungen durch Hinzufügen von [allow_writeable_chroot=YES].

Jeweils Dienstneustart nicht vergessen.

|

Clientzugriff Varianten ein-/ausblenden:

Zugriffsmöglichkeiten für den Client gibt es viele. Ich möchte hier nur ein paar ausgewählte gängige vorstellen:

Zugriff auf den Server mit FileZilla (Windows):

Hierzu muss man im Servermanager von FileZilla folgende Einstellungen vornehmen:

Server: IP-Adresse oder Domain

Port: 21 (kann man leer lassen)

Protokoll: FTP - File Transfer Protocol

Verschlüsselung: Explizites FTP über TLS anfordern

Benutzername: Benutzername

Passwort: Geheim (kann man auch weglassen - dann wird gefragt)

Zugriff auf den Server mit WinSCP (Windows):

In der Anmeldemaske muss man folgende Einstellungen vornehmen:

File protocol: FTP

Encryption: TLS/SSL Explicit encryption

Host name: IP-Adresse oder Domain

Port number: 21

User name: Benutzername

Password: Geheim (kann man auch weglassen - dann wird gefragt)

Zugriff auf den Server mit dem Browser-Plugin FireFTP (MultiOS/Cross-Platform):

Zuerst muss man die Erweiterung im Webbrowser installieren:

Im Firefox am einfachsten installieren über Menü [Extras] > [Add-ons] > [Erweiterungen],

hier in der Suchmaske oben rechts [FireFTP] eingeben und auf [Installieren] klicken.

Nach einem Browserneustart ist FireFTP aktiv.

Damit der Zugriff zum Server richtig funktioniert, muss in der [vsftpd.conf] der Eintrag [require_ssl_reuse=NO] vorhanden sein (Dienstneustart nicht vergessen).

Der Aufruf eines Servers funktioniert dann über: ftps://IP-Adresse_oder_Domain

Zugriff auf den Server mit dem Total Commander

mit dem Secure FTP Plugin (Windows):

Der Total Commander kann auch mit Hilfe des Secure-FTP-Plugins

nicht auf einen

FTPS-Server zugreifen.

Das Secure-FTP-Plugin im Total Commander

erwartet auf der Serverseite

zwingend einen

SFTP-Server.

Und vsftpd stellt aber nur einen FTPS-Server bereit. Also muss man einen zusätzlichen SFTP-Server einrichten.

Wie man einen SFTP-Server installiert habe ich unter dem

Punkt 15 beschrieben.

Hinweis zum Internet Explorer:

Der IE fragt nicht nach einem Benutzernamen & Passwort (er versucht immer eine Anonyme Anmeldung und bringt dann einen Fehler). Verwendet daher zum Testen einen anderen Browser.

Lösung: Der Zugriff über den IE klappt nur so (Namen, Passwort & IP-Adresse muss man entsprechend ändern):

ftp://Benutzername:Passwort@192.168.2.1

Ein paar wichtige optionale Parameter:

anon_upload_enable=YES # anonymous Anmeldungen Schreibzugriff erlauben (Verzeichnisrechte und [write_enable=YES] werden benötigt).

anon_mkdir_write_enable=YES # anonymous Anmeldungen das Erstellen von Verzeichnissen erlauben (Verzeichnisrechte und [write_enable=YES] werden benötigt).

anon_root=/data/directory # Den FTP-Pfad für die Anonyme Anmeldung festlegen.

anon_other_write_enable=YES # Erlaubt auch andere Dateioperationen wie Löschen oder Umbenennen oder Verzeichnisse zu erstellen.

anon_max_rate=10240 # Transferate in Bytes/Sekunde für Anonyme User (0=unbegrenzt/Standard).

local_max_rate=10240 # Transferrate in Bytes/Sekunde für lokale User mit Anmeldung (0=unbegrenzt/Standard).